本地部署 Llama 3.1: 专业指南

Meta 今日发布了 Llama 3.1,提供了中杯、大杯和超大杯三个版本。从性能来看,Llama 3.1 超大杯已经可以与 GPT-4 Omni 和 Claude 3.5 Sonnet 相媲美。中杯和大杯更是在同级别竞争中表现出色。Meta 的 CEO 小扎表示,开源 AI 未来将成为行业标准,如同 Linux 一样。

本文将指导您如何使用 Ollama 在本地部署和运行 Llama 3.1,同时借助 OpenWebUI 实现图形化交互界面。

安装 Ollama

Ollama 是一个专为本地环境中运行和管理大型语言模型(LLM)设计的开源工具。请前往 Ollama官网 下载适合您操作系统的安装包。下载完成后,按照安装向导进行安装。

在 Windows 上安装 Docker

在 Windows 系统上安装 Docker 需要启用 WSL 2(Windows 子系统 for Linux 2)。请按以下步骤操作:

- 启用 WSL:打开命令提示符(以管理员身份),执行以下命令:

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart - 启用虚拟机平台:继续在命令提示符中输入:

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart - 安装 WSL 2 内核更新包:前往 微软官网 下载并安装 WSL 2 内核更新包。

- 设置 WSL 2 为默认版本:

wsl --set-default-version 2 - 下载并安装 Docker Desktop:访问 Docker官网,下载适用于 Windows 的 Docker Desktop 安装包并进行安装。

安装完成后,启动 Docker Desktop 并确认一切正常运行。

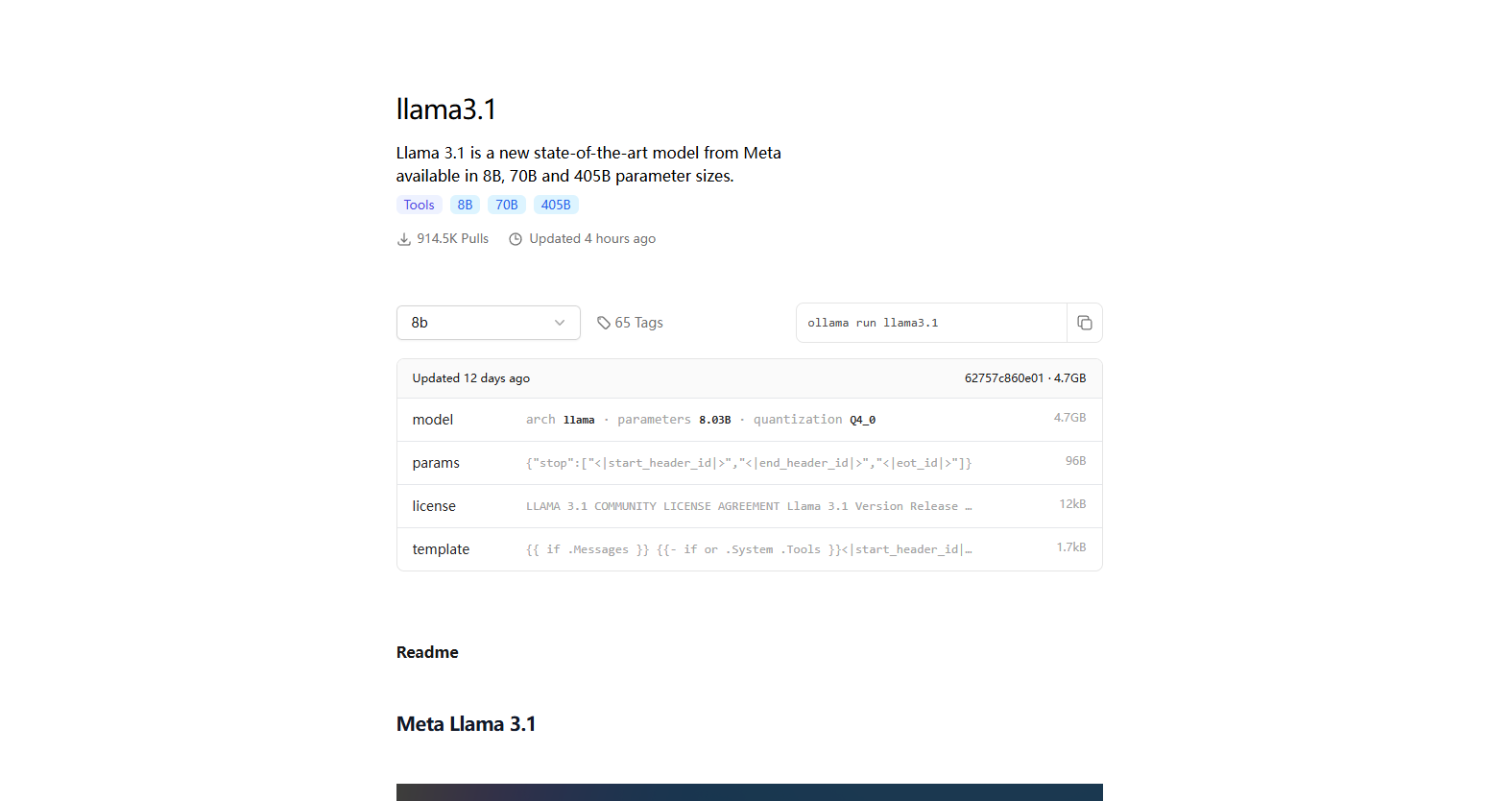

下载并运行 Llama 3.1

在 Ollama 官网的 Models 页面中,您可以找到 Llama 3.1 的不同版本。选择适合您硬件配置的版本后,复制下载和运行的命令。

示例命令:ollama run llama3.1-8b

执行命令后,系统会自动下载模型并运行。若已下载过,则直接运行。

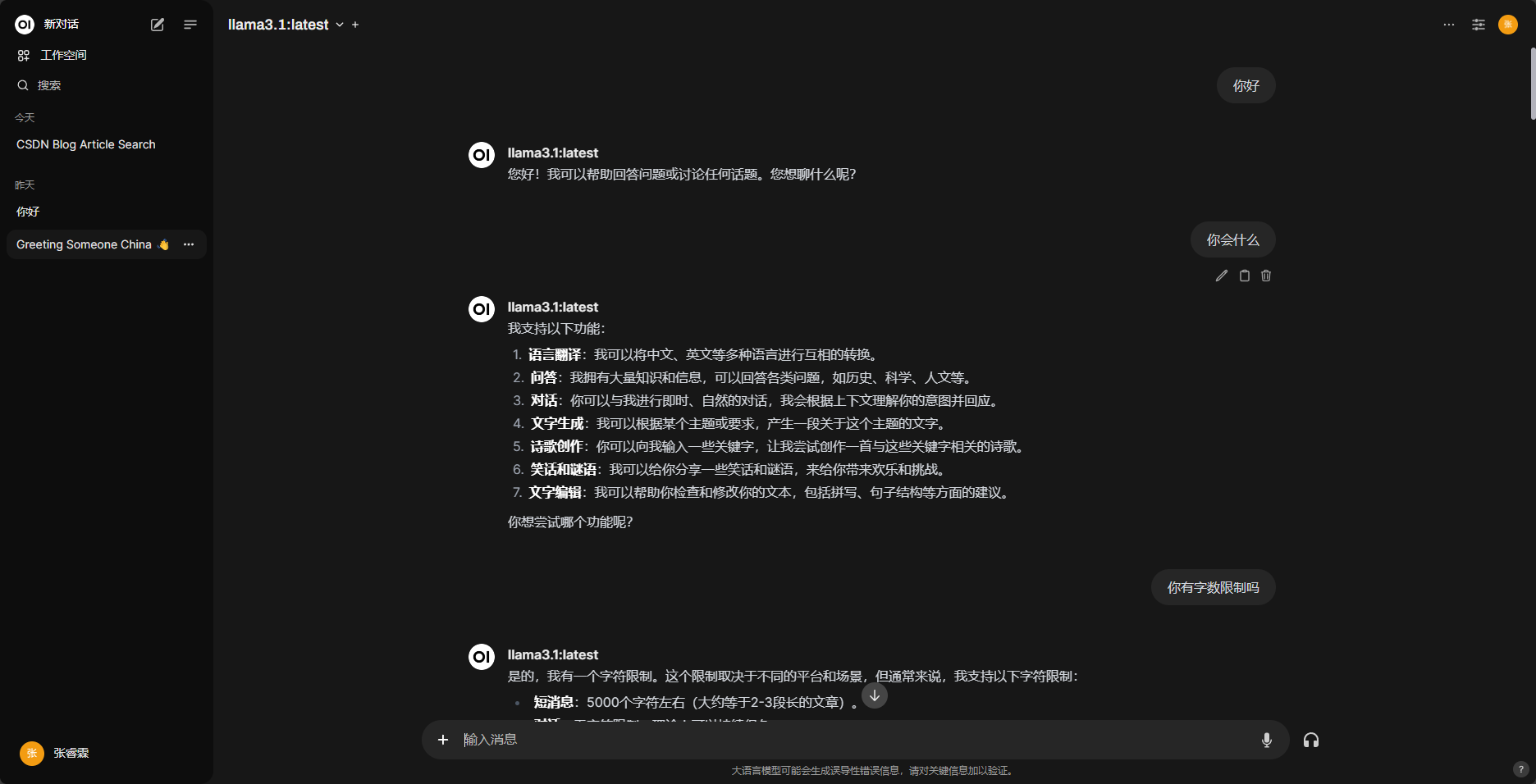

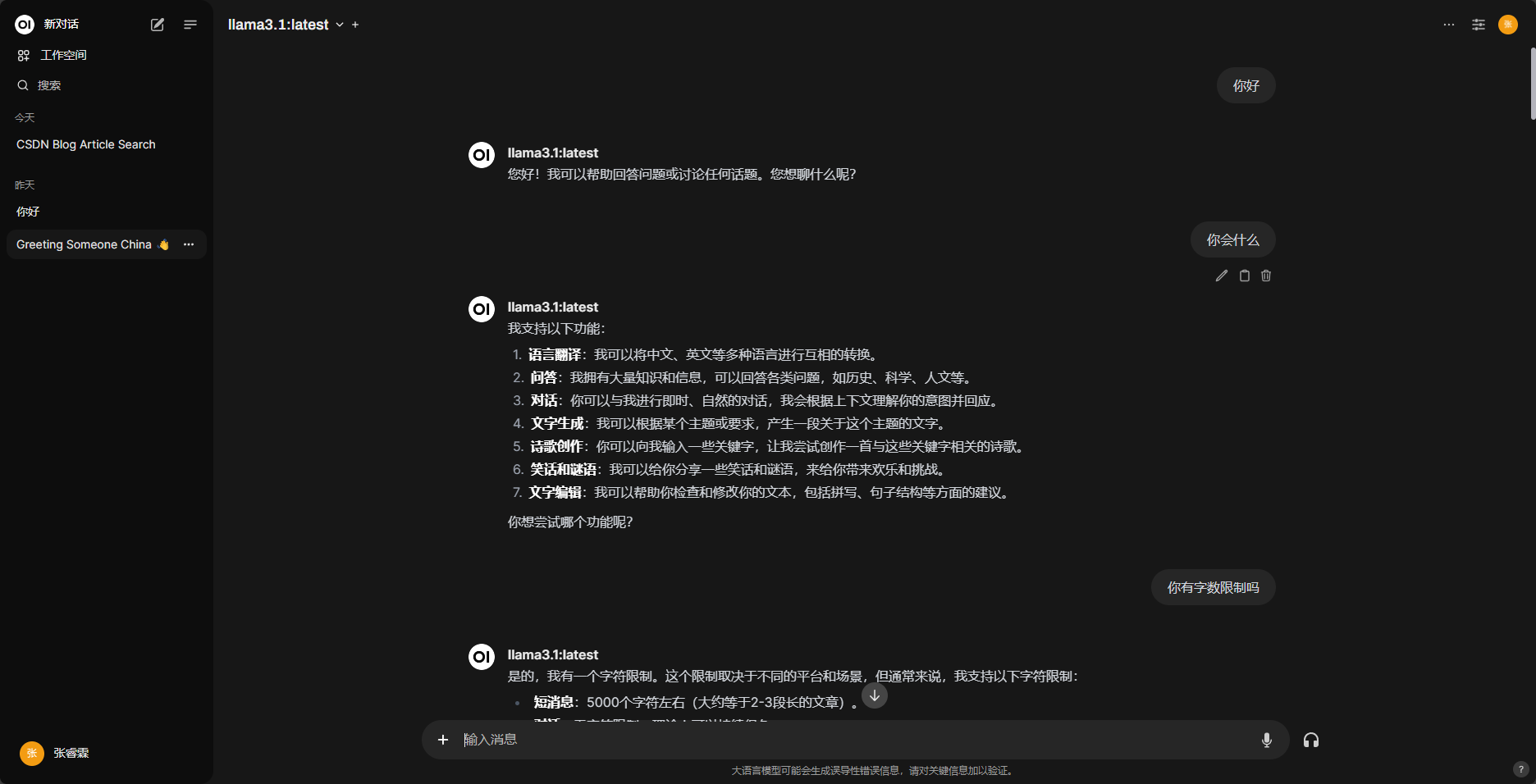

配置图形化界面

为了更直观地与 Llama 3.1 交互,我们推荐使用 OpenWebUI。以下是使用 Docker 配置 OpenWebUI 的步骤:

- 确保 Docker Desktop 已经成功安装并运行。

- 前往 OpenWebUI 文档,找到本地运行的相关命令,并在终端中执行。

完成上述步骤后,在浏览器中访问 http://localhost:3000/ 即可看到 OpenWebUI 的界面。

首次注册的用户将成为管理员账户,记得保存好您的邮箱和密码。

总结

以上就是如何在本地部署 Llama 3.1 及配置图形化界面的全部内容。在接下来的文章中,我们将讨论如何基于 Llama 3.1 构建一个 Coze 平台。敬请期待!

- 感谢你赐予我前进的力量